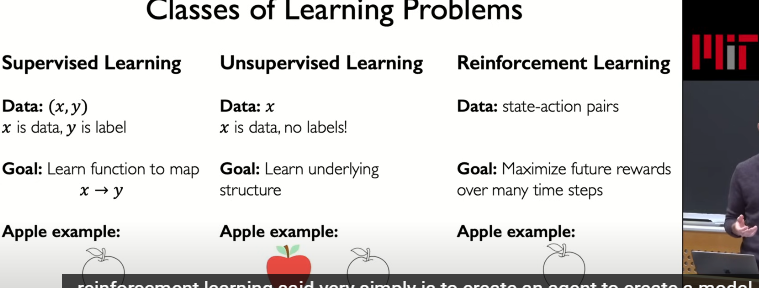

1. 概述

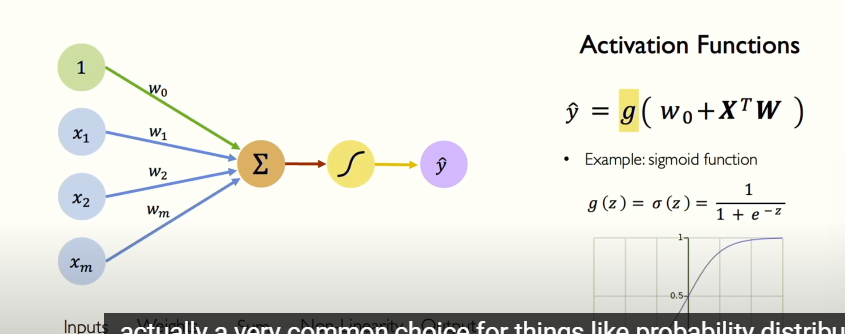

1.1. 感知器

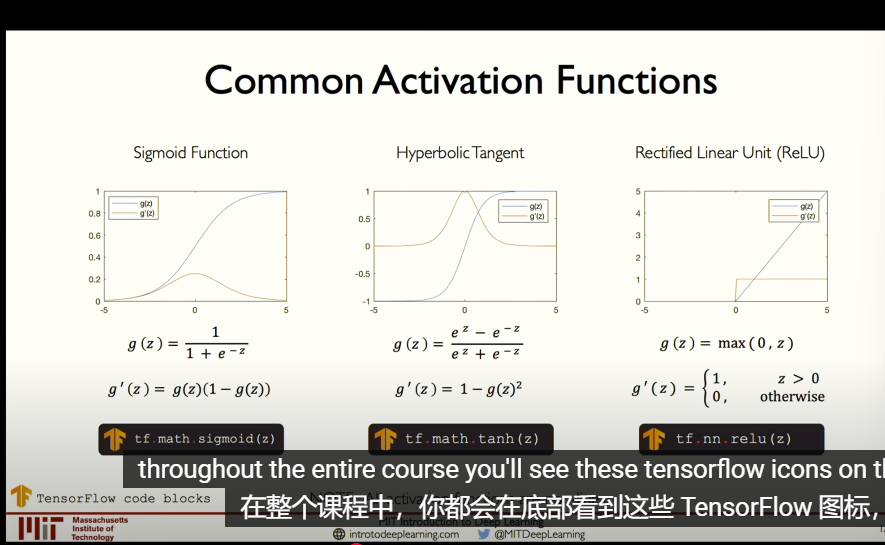

1.2. 激活函数

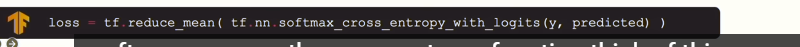

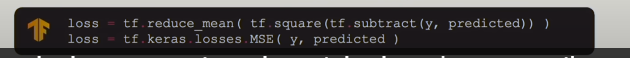

1.3. 损失函数

1.3.1. 分类

1.3.2. 定量

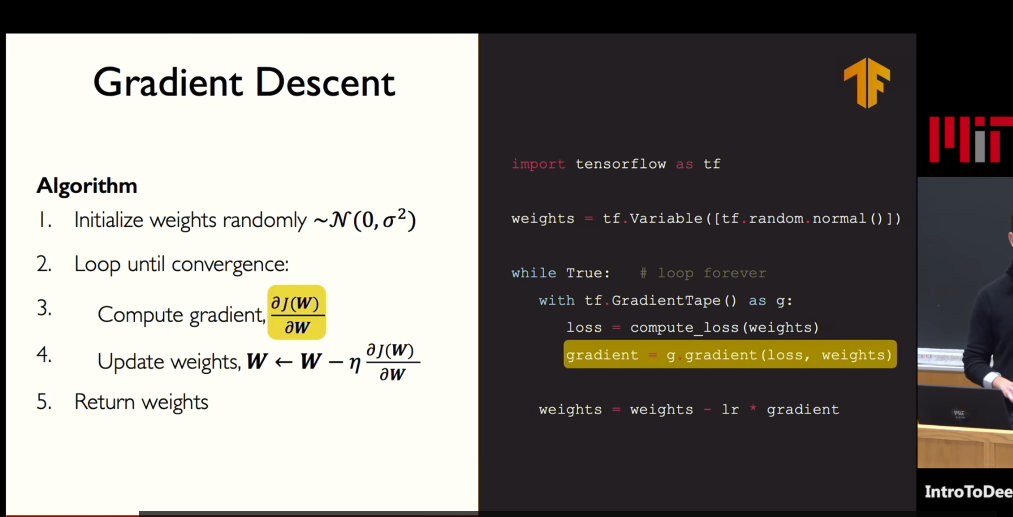

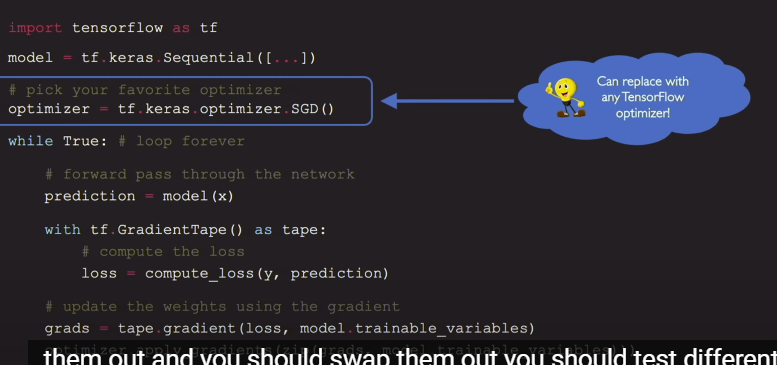

1.4. 梯度下降

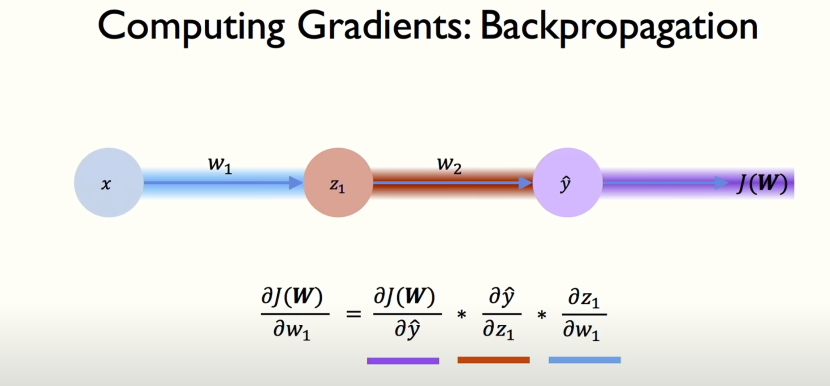

1.5. 反向传播

- 反向传播(Backpropagation):

- 反向传播是通过计算损失函数关于每个权重的梯度,来更新网络的权重。

- 从输出层开始,逐步向后(即从神经网络的最后一层到第一层)计算每个神经元对总损失的贡献。这被称为“反向传播”,因为它是沿着网络反向传播误差信号。

1.5.1. 反向传播的步骤

- 计算输出层的误差:

- 比较预测值和真实值,计算输出层的误差。

- 计算梯度:

- 使用链式法则(Chain Rule)计算每一层的梯度,这样就可以知道每个权重对于损失的影响。

- 更新权重:

- 知道了梯度后,就可以使用一定的学习率(learning rate)来调整权重,使得损失下降。具体来说,如果权重导致了更高的损失,就往反方向调整它。

1.6. 学习率

学习率自动调整算法

1.7. 分批梯度下降

?

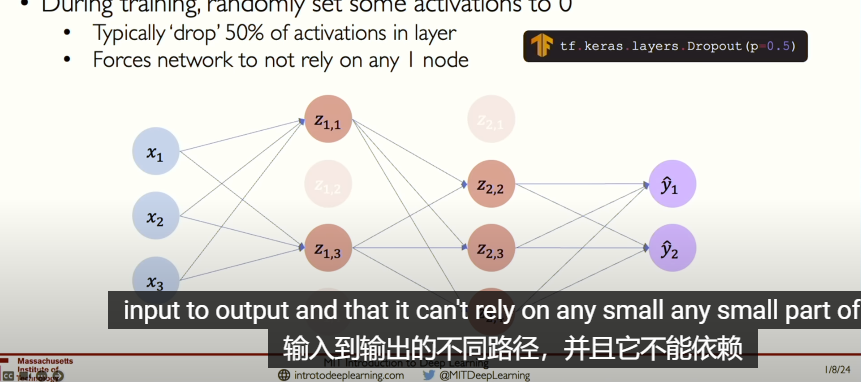

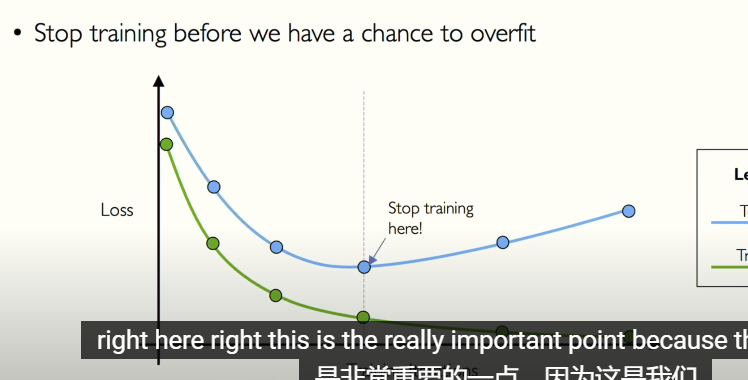

1.8. 正则化和早停机制

随机丢失部分神经元

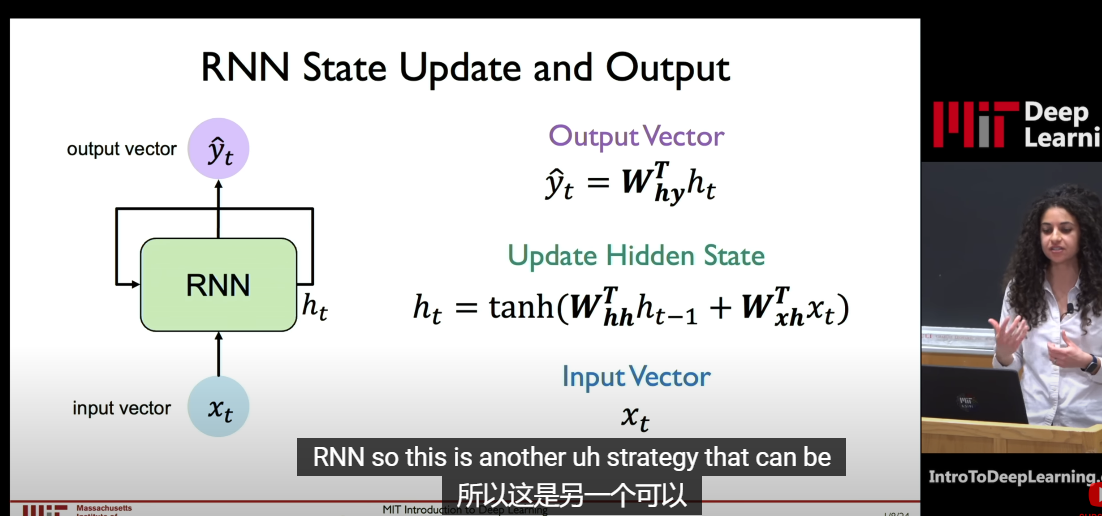

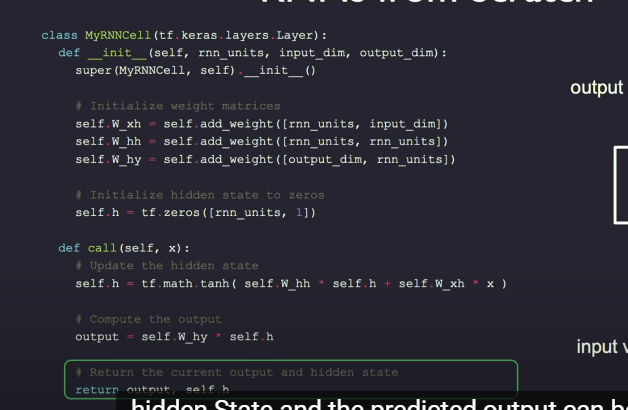

2. RNN

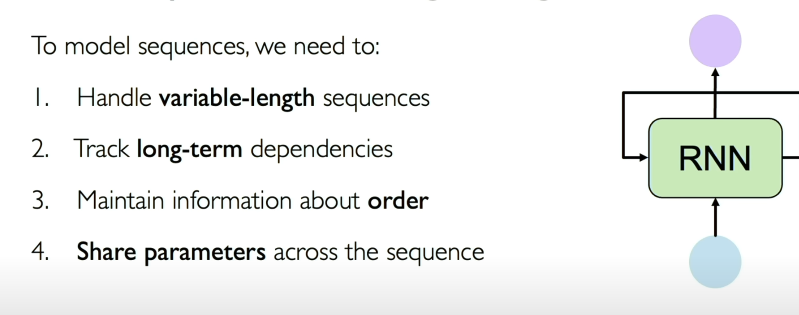

2.1. 顺序建模的设计标准

Word prediction example 31:50 - Backpropagation through time 33:40 - Gradient issues 37:15 - Long short term memory (LSTM) 40:00 - RNN applications 44:00- Attention fundamentals 46:46 - Intuition of attention 49:13 - Attention and search relationship 51:22 - Learning attention with neural networks 57:45 - Scaling attention and applications 1:00:08 - Summary

2.2. 随着时间反向传播-梯度消失,学习能力下降

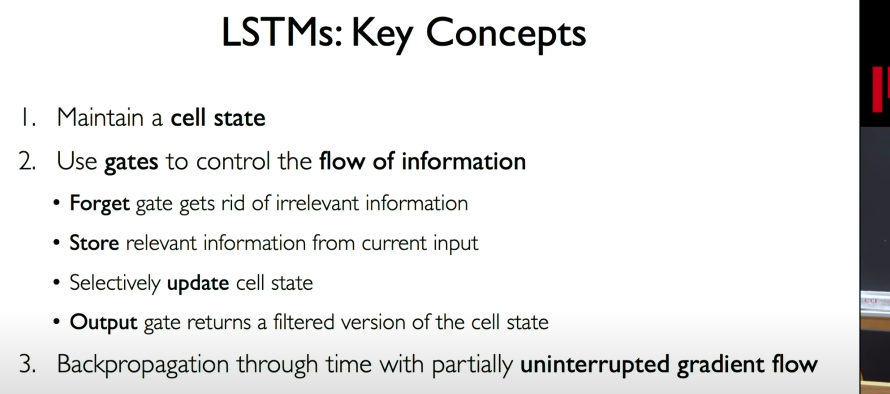

2.3. lstm

通过忘记一部分

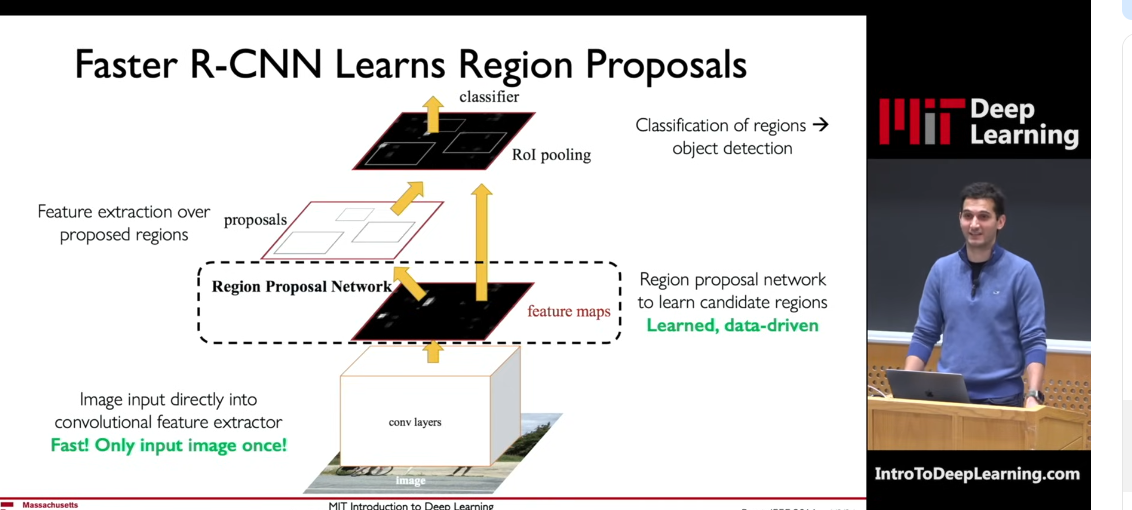

3. 卷积神经网络

获取不同框中的物体,两个神经网络共同使用。

4. 强化学习

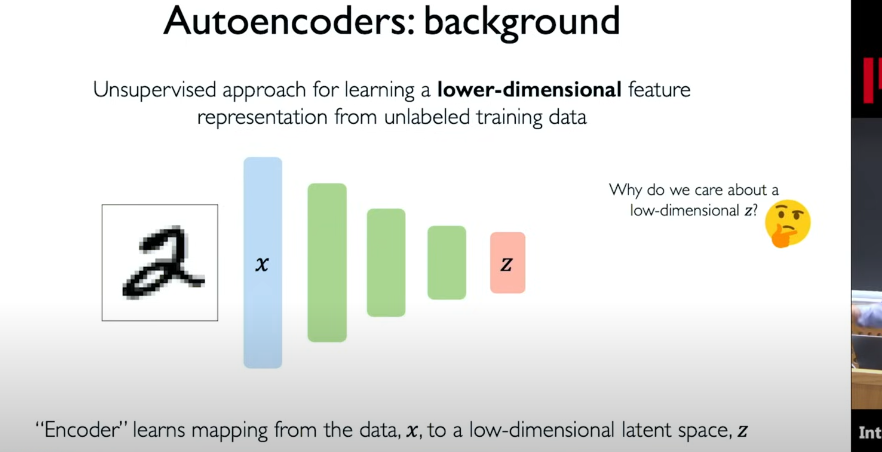

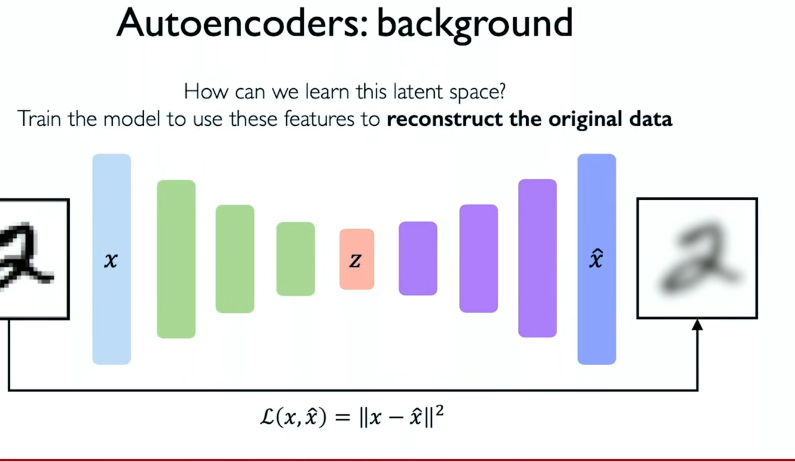

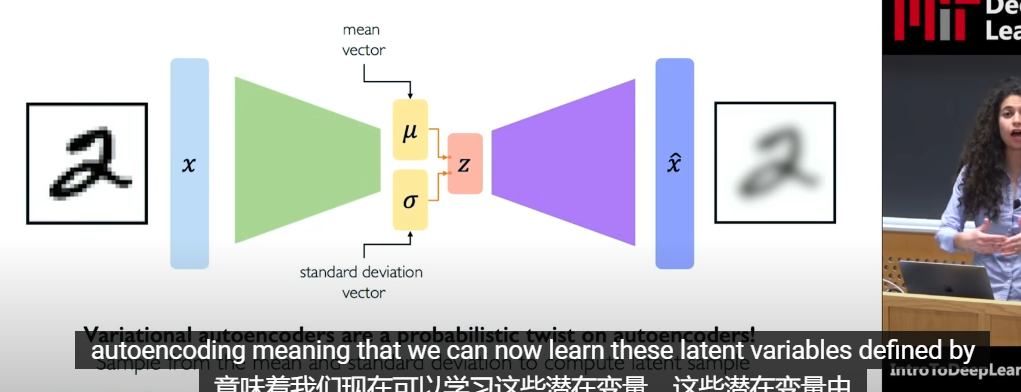

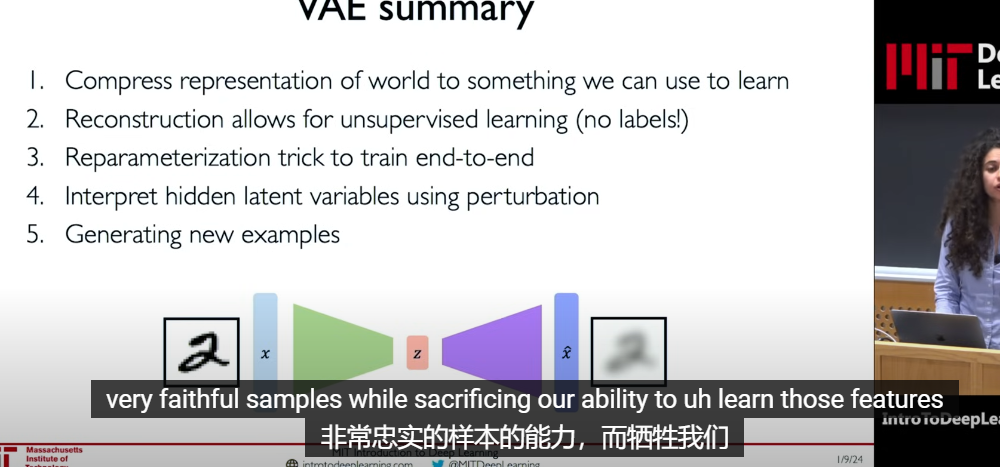

4.1. 自动编码器

将数据编码,降维

解码器

增加概率扭曲

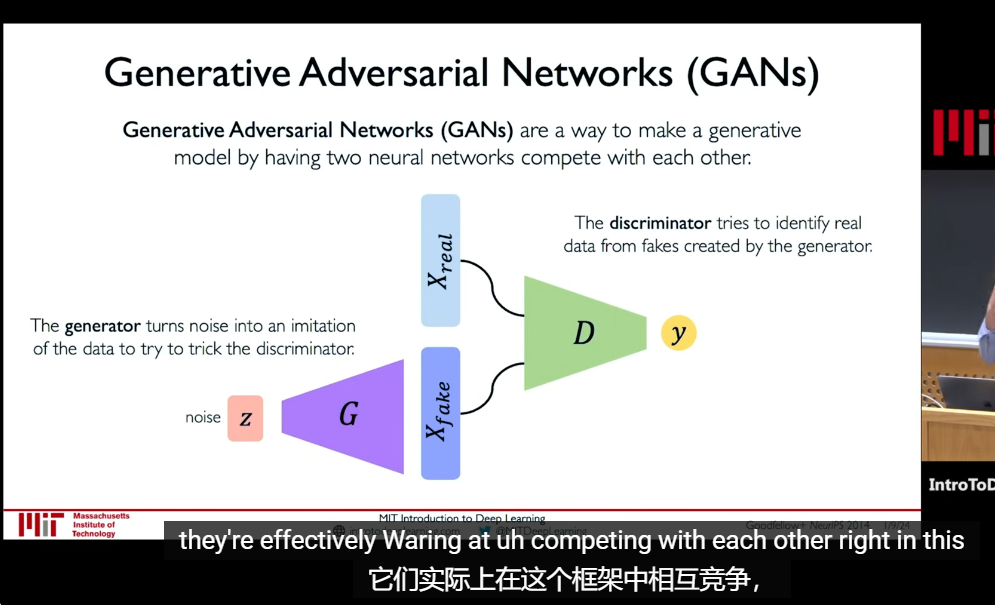

4.2. 生成式对抗网络

4.3. 强化学习